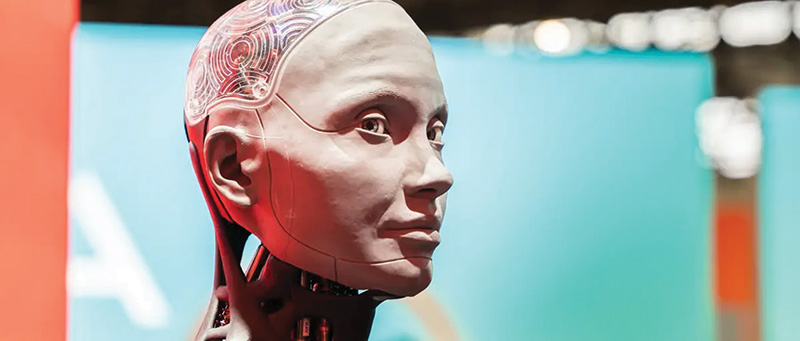

(KTSG) - Trí tuệ nhân tạo (AI) đang dần trở nên phổ biến hơn trong cuộc sống hàng ngày và được ứng dụng vào nhiều sản phẩm, dịch vụ khác nhau. Tuy nhiên, một số công ty đang phóng đại về việc sử dụng AI khi tiếp thị sản phẩm và dịch vụ của mình, và điều này có thể dẫn đến những cái nhìn tiêu cực hơn đối với công nghệ AI.

- TPHCM: cảnh báo tình trạng quảng cáo giảm béo công nghệ cao trái phép

- GenAI và tính ứng dụng trong quảng cáo và tiếp thị

Những thông điệp phóng đại, giả mạo về AI

Hãy tưởng tượng điều này: Bạn muốn mua chiếc máy hút bụi mới nhất, bạn đến cửa hàng trực tuyến yêu thích của mình và bắt đầu lướt qua điện thoại di động hoặc máy tính bảng để tìm kiếm. Sau đó, bạn thấy một sản phẩm được gắn kèm tuyên bố rằng nó được hỗ trợ bởi công nghệ AI tiên tiến. Điều này khiến nó có vẻ siêu công nghệ cao và thông minh.

Tuy nhiên, trên thực tế, thiết bị này chỉ có một nút cảm biến đơn giản để đảm bảo nó không va vào đồ đạc khi đang di chuyển mà thôi. Không có gì đặc biệt hay đột phá cả. Đây là một hình thức giả mạo AI (AI washing), tức là làm cho sản phẩm nghe có vẻ hấp dẫn hơn hoặc thông minh hơn bằng cách tuyên bố rằng chúng được ứng dụng công nghệ AI trong khi chúng thực ra chỉ có những tính năng thông thường.

Theo DW, việc các công ty phóng đại quá mức về tính năng AI trong sản phẩm của mình có thể gây ra một số tác động tiêu cực. Đầu tiên, những sự đổi mới thực sự của AI có thể bị chôn vùi dưới các tuyên bố cường điệu, khiến mọi người khó có thể phát hiện ra những đột phá thực sự. Thứ hai, tình trạng này khiến mọi người hoài nghi đối với những tuyên bố về AI, từ đó dần không còn tin tưởng hoàn toàn vào công nghệ nữa.

Ông Christoph Lütge, chuyên gia tại Viện Đạo đức về trí tuệ nhân tạo có trụ sở tại Munich, nói rằng vì thuật ngữ AI được sử dụng theo những cách rất khác nhau nên có rất nhiều khái niệm mà các công ty có thể dễ dàng lợi dụng để đưa ra những quảng cáo phóng đại, sai sự thật.

“Thách thức là ở chỗ rất khó để xử lý vấn đề này từ góc độ pháp lý, vì AI là một thuật ngữ khá mơ hồ. Từ quan điểm đạo đức, mọi thứ có thể hiệu quả hơn. Sẽ là rất tốt khi có một chuyên gia đến và hướng dẫn các cơ quan quản lý và xã hội dân sự xử lý vấn đề từ góc độ quan điểm đạo đức”.

Theo Trung tâm Người tiêu dùng châu Âu (ECC) tại Đức, sau những tranh chấp liên quan đến vấn đề xanh giả (green washing) - những tuyên bố vô căn cứ để đánh lừa người tiêu dùng tin rằng các sản phẩm của công ty là thân thiện với môi trường, vấn đề giả mạo AI chắc chắn sẽ nhận được nhiều sự chú ý hơn. Tuy nhiên, việc giải quyết vấn đề này sẽ không hề đơn giản.

Người phát ngôn của ECC, Karolina Wojtal, cho biết: “Điều quan trọng là người tiêu dùng phải có khả năng chứng minh rằng các tuyên bố được doanh nghiệp đưa ra là sai lệch, và cung cấp những bằng chứng đáng tin cậy về điều đó, bởi vì hiện nay mọi người đều cố gắng sử dụng AI như một cách để thu hút sự chú ý của khách hàng”.

Thách thức lớn cho các nhà đầu tư và doanh nghiệp

Những quảng cáo phóng đại, giả mạo AI cũng đang là vấn đề khiến nhiều nhà đầu tư đau đầu, bởi họ có thể bỏ lỡ những dự án thực sự có tiềm năng vì thông tin quá nhiễu loạn. Ngược lại, các công ty cũng có thể bắt đầu hướng tới những mục tiêu không tưởng, tin rằng AI có thể làm được nhiều hơn những khả năng thực sự mà nó có.

Một số công ty có thể quảng cáo về công nghệ AI trong sản phẩm của họ trước khi ra mắt. Và mặc dù công ty mới chỉ có ý định đưa AI vào sản phẩm tại một thời điểm nào đó, nhưng họ có thể đưa ra quảng cáo như thể sản phẩm đã chứa công nghệ AI rồi.

Trong một số trường hợp khác, các công ty chỉ cần thêm giao diện chatbot được tạo sẵn vào một sản phẩm thông thường là đủ để gắn mác AI, dù điều này không làm cho sản phẩm tốt hơn chút nào. Họ cũng có thể sử dụng các tính toán học máy phức tạp để thực hiện các nhiệm vụ có thể được thực hiện với ít năng lượng hơn, ít dữ liệu hơn và với chi phí thấp hơn.

Theo ông Joerg Heidrich, luật sư và chuyên gia về AI đã được cấp bằng chứng nhận, làm việc tại Hannover, Đức, nhìn chung mọi người đều biết về vấn đề giả mạo AI, nhưng không phải ai cũng nắm rõ cách thức các hình thức giả mạo này được áp dụng trong sản phẩm và dịch vụ.

Một báo cáo hồi năm 2019 của Công ty đầu tư mạo hiểm MMC Ventures có trụ sở tại London cho thấy, trong số hơn 2.830 công ty khởi nghiệp ở châu Âu được phân loại là công ty AI, có tới 40% trên thực tế không liên quan gì đến AI cả.

Xu hướng gắn mác bừa bãi cho các sản phẩm AI được dự báo sẽ còn gia tăng hơn nữa trong bối cảnh làn sóng AI đang bùng nổ mạnh mẽ. Một số chuyên gia ước tính, việc xây dựng cơ sở hạ tầng AI có thể sẽ tiêu tốn hơn 1.000 tỉ đô la Mỹ chỉ trong vài năm tới, bao gồm chi tiêu cho các trung tâm dữ liệu, tiện ích và ứng dụng.

Trong bối cảnh hoạt động chi tiêu thiếu sự kiểm soát chặt chẽ, một số người, như nhà đầu tư công nghệ kỳ cựu Roger McNamee, lo ngại rằng các công ty sẽ sử dụng các sản phẩm máy học và các mô hình ngôn ngữ lớn (LLM) theo những cách không mang lại bất kỳ giá trị nào. Dĩ nhiên, những sản phẩm như vậy vẫn được tính là AI, nhưng nếu AI không mang lại bất kỳ giá trị nào thì chúng cũng có thể coi là một phần trong các hành vi phóng đại, giả mạo AI.

Các nỗ lực xử lý các quảng cáo AI sai lệch

Hồi đầu năm nay, Ủy ban Chứng khoán và Sàn giao dịch Mỹ (SEC) cho biết, đã giải quyết các cáo buộc đối với hai công ty đầu tư, Delphia và Global Predictions, vì đã đưa ra những tuyên bố sai lệch và gây hiểu lầm về mục đích sử dụng AI của họ. Các công ty đã đồng ý dàn xếp các cáo buộc của SEC và trả tổng số tiền phạt là 400.000 đô la (368.000 euro).

Theo SEC, Công ty Delphia có trụ sở tại Toronto (Canada) đã đưa ra những tuyên bố sai lệch rằng họ “đã dùng dữ liệu thu thập được để làm cho sản phẩm AI của công ty trở nên thông minh hơn, có thể dự đoán được những công ty và xu hướng nào sắp phát triển và từ đó tiến hành đầu tư đón đầu trước những người khác”. Tuy nhiên, trên thực tế là các sản phẩm này không có khả năng AI và học máy như công ty đã tuyên bố.

Trong khi đó, Global Predictions có trụ sở tại San Francisco (Mỹ) cũng tuyên bố sai lệch trên trang web và trên mạng xã hội rằng họ cung cấp dịch vụ “cố vấn tài chính được quản lý bằng AI đầu tiên” và nền tảng của họ có thể cung cấp “những dự báo từ các chuyên gia AI”.

Trong một thông cáo báo chí, Chủ tịch SEC, Gary Gensler, cho biết: “Chúng tôi đã nhiều lần chứng kiến rằng khi các công nghệ mới xuất hiện, chúng có thể khiến các nhà đầu tư kinh ngạc, nhưng đồng thời cũng dẫn tới những tuyên bố phóng đại, sai lệch từ những người có ý định lợi dụng những công nghệ mới đó để kiếm lợi”.

Mới đây nhất, vào giữa tháng 6-2024, SEC cũng đã khởi kiện nhà sáng lập, cựu tổng giám đốc điều hành Joonko, vì nền tảng tuyển dụng trực tuyến này từng tuyên bố họ sử dụng AI để kết nối các công ty cần tuyển dụng với các ứng viên xuất thân từ các nhóm người ít được chú ý. Trong số các cáo buộc, SEC cho rằng Joonko hoàn toàn không sử dụng gì dính líu đến AI như họ tuyên bố.

Các công ty lớn như Coca-Cola và Amazon cũng phải đối mặt với phản ứng dữ dội vì bị cáo buộc tham gia vào các hành động giả mạo AI. Vào tháng 9-2023, Coca-Cola đã ra mắt sản phẩm đồ uống Y3000, một hương vị mới mang phong cách tương lai mà hãng tuyên bố là do AI “đồng sáng tạo”.

Tuy nhiên, nhìn chung, việc xử lý vấn đề này còn rất nhiều thách thức, bởi để xác định một quảng cáo AI có phóng đại hay sai sự thực hay không là rất khó. Một phần nguyên nhân bởi vì cho đến nay, vẫn không có khái niệm chính xác và được chấp nhận một cách phổ biến về AI.

Tại châu Âu, tình hình được kỳ vọng sẽ có sự cải thiện, sau khi Đạo luật AI của Liên minh châu Âu (EU) có hiệu lực từ ngày 1-8-2024, với các điều khoản sẽ dần dần được đưa vào thực hiện trong vòng 6-36 tháng tiếp theo. Trong đó, đáng chú ý có một danh mục rủi ro hạn chế, đảm bảo rằng người dùng sẽ được thông báo rằng họ đang tương tác với hệ thống AI, từ đó cho phép họ đưa ra quyết định sáng suốt.

Theo chuyên gia Heidrich: “Mặc dù Đạo luật AI không chịu trách nhiệm quản lý lĩnh vực giả mạo AI, nhưng nó có thể hữu ích vì đạo luật đảm bảo các tổ chức sẽ phải đưa ra những thông tin rất minh bạch về công nghệ AI của mình. Điều này có thể giúp gián tiếp hạn chế các quảng cáo sai sự thật từ các công ty”.

Nguồn : DW, Forbes, Aveva